Ny avhandling om ökad tillförlitlighet för maskininlärningsmetoder

Kan man förlita sig på automatiserade beslut som är gjorda av komplexa maskininlärningsprocesser, med tanke på att sådana modeller inte hålls ansvariga för sina förutsägelser? Angelos Chatzimparmpas forskning förenklar översikten av och hanteringen av maskininlärningsalgoritmer så att mänskliga experter kan utvärdera hur automatiserade beräkningslösningar uppnår sina resultat.

Vårt samhälle är beroende av intelligenta maskiner som redan nu är väldigt exakta och kraftfulla. De har förmågan att lösa komplexa problem, allt från rekommendationssystem för att bestämma vilken film man ska se härnäst till medicinska diagnoser i samband med att en patient blir intagen på sjukhus.

Experter inom högriskdomäner behöver dock veta vad en specifik förutsägelse har baserats på innan de kan förlita sig på maskinginlärningsprocessen och dess resultat. I sin doktorsavhandling har Chatzimparmpas studerat problematiken för att kunna presentera effektiva lösningar.

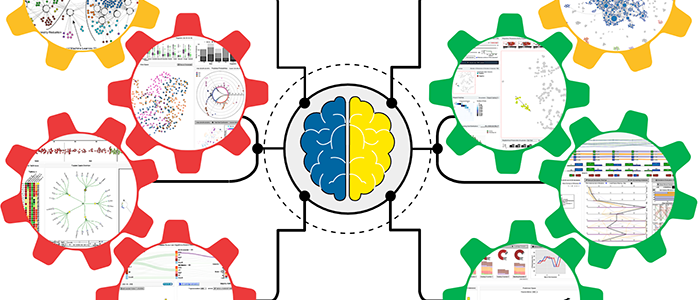

– Min forskning visar hur användare av maskininlärning kan dra nytta av visuella analysverktyg och system som bidrar med förklarbarhet, ökar tillförlitligheten och leder maskininlärningsmetoderna genom interaktiva visuella representationer, det vill säga speciella typer av diagram och grafer som kan påverkas av användarna, berättar Chatzimparmpas.

Som en del av doktorandprojektet har Chatzimparmpas och hans kollegor tagit fram ett digitalt verktyg som nu är tillgängligt över hela världen för forskare, utövare och studenter som är intresserade av visualisering för maskininlärning https://trustmlvis.lnu.se/).

De har även designat och utvecklat ett flertal visuella, analytiska förhållningssätt som gör det möjligt för maskininlärningsexperter och modellutvecklare att förbättra alla steg i ett heltäckande arbetsflöde kring maskininlärning.

Såväl akademisk forskning som affärsinriktad verksamhet kan ha användning av de tillvägagångssätt Chatzimparmpas presenterar i sin avhandling. Ett exempel från den finansiella världen är att beslut om att avslå låneansökningar måste vara mer transparanta och i detalj förklara varför de fick avslag.

Förståelse för algoritmer

För att kunna bygga tillit mellan människor och datorer är det viktigt att kunna förstå hur en algoritm fungerar och kunna förklara hur den kommer fram till ett visst beslut efter det att en förutsägelse har gjorts. Detta är kärnan i den utmaning som Chatzimparmpas behandlar i sin studie.

– I takt med det ökande användandet av komplexa maskininlärningstekniker för många analytiska uppgifter ökar även behovet av tolkningsbara och förklarliga lösningar. Jag tror att man utan att sticka ut hakan för mycket kan hävda att visuell analys för förklarlig och tillförlitlig maskininlärning kommer att fortsätta att ligga i framkant som forskningsämne inom en överskådlig framtid, fortsätter Chatzimparmpas.

Nya spännande utmaningar väntar för Chatzimparmpas då han från och med mars 2023 kommer att ansluta sig till MU Collective research lab vid Northwestern University i USA. Där kommer han att fortsätta sin forskning som postdoktor, med målet att göra visualisering som modellkontroll för maskininlärning mer formell och ytterligare djupdyka i detta ämne.

Slutligen kommer han att jobba för att ta fram nya sätt för att testa hur väl utforskande och bekräftande visuella analysverktyg fungerar.

Mer information

Avhandlingen skrevs vid institutionen för datavetenskap och medieteknik. Forskningen är del av forskargruppen ISOVIS och Linnaeus University Centre for Data Intensive Sciences and Applications (DISA).

- Doktorsavhandlingen Visual analytics for explainable and trustworthy machine learning finns att läsa här: https://doi.org/10.15626/LUD.482.2023

Kontakt

Angelos Chatzimparmpas, doktorand, 0470-70 81 77, angelos.chatzimparmpas@lnu.se