Kan vi lita på att smarta robotar tar rätt beslut?

Om artificiella intelligenser tränas på felaktig information så gör den fel. Men oavsett om all indata är korrekt och värdeneutral, så behöver vi bygga in en moral. Vem är ansvarig för AI:n:s beslut?

I takt med den tekniska utvecklingen blir AI en allt större del av våra liv, och vi kommer alla att påverkas av deras beslut.

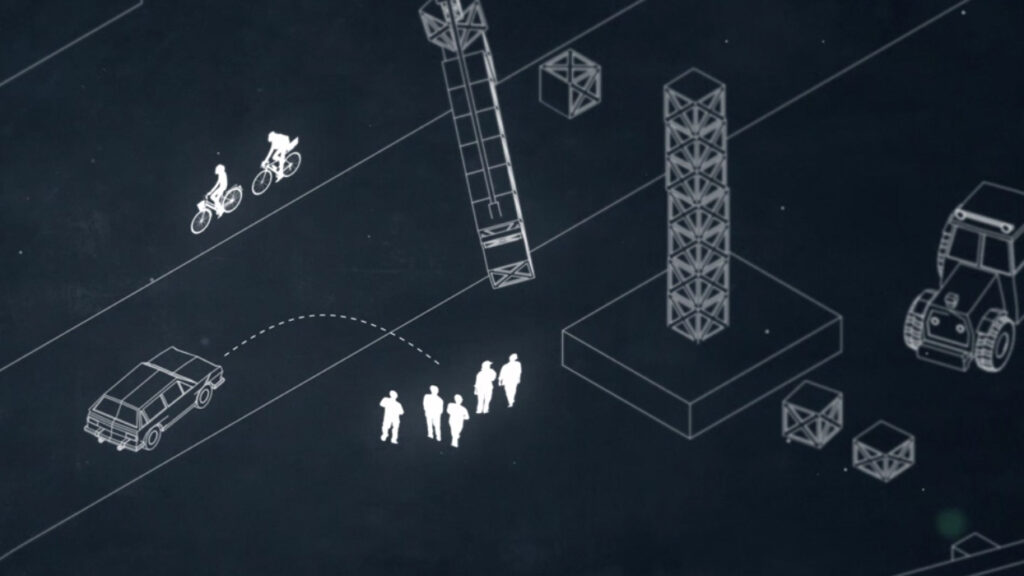

Vi gör ett tanke-experiment: Du åker i en självkörande bil som är programmerad för att göra minsta möjliga skada.

Plötsligt uppstår ett hinder på gatan och bilen färdas så fort att den inte kommer hinna bromsa! Vad ska bilen göra? Om den väjer vänster så träffar den och dödar två cyklister. Om den väjer höger så dödar den fem personer. Två mot fem.

Men om de fem gångtrafikanterna är barn?

Eller om du själv sitter i bilen, ensam, och den moraliska regeln väljer att köra rakt in i hindret, och kanske döda dig, för att rädda de två cyklisterna och de fem gångtrafikanterna?

Enkel regel blir snabbt komplicerad

Tanke-experimentet visar hur en enkel regel snabbt blir komplicerad. Borde systemet värdera risker efter antal människoliv, eller ålder eller något annat?

Artificiella intelligenser, AI, lär sig av datan den hanterar. Tränas den på felaktig information så gör den fel. Även om vi upplever informationen som korrekt, så kan den vara full av mänskliga värderingar, vilka i sin tur påverkar AI:ns beslut.

Och vem är ansvarig för de beslut som ett smart system tar? Programmeraren? Tillverkaren? Användaren? Eller rent av roboten själv?

Kunskapsöversikt:

forskning.se:s kunskapsöversikt om artificiell intelligens: http://www.ai.forskning.se